文献阅读笔记-Pay Attention to Raw Traces: A Deep Learning Architecture for End-to-End Profiling Attacks Analysis

文章信息

- 作者:Xiangjun Lu, Chi Zhang, Pei Cao, Dawu Gu, Haining Lu

- 单位:Shanghai Jiao Tong University, Shanghai, China

- 出处:IACR Transactions on Cryptographic Hardware and Embedded Systems

- 标题:Pay Attention to Raw Traces: A Deep Learning Architecture for End-to-End Profiling Attacks

- 日期:2021年7月9日

研究背景

深度神经网络与侧信道攻击相结合对加密设备造成了巨大的威胁,但大部分文章都是基于一个假设前提,即攻击者攻击的兴趣点区间是基于先验知识挑选出来的,为了完全基于黑盒对设备发起侧信道攻击,作者直接将原始能量迹作为输入来完成“端到端”的侧信道攻击。

文章内容

本文贡献

- 提供了针对不同数据集端到端建模攻击的模型框架

- 探索了注意力机制在侧信道攻击中的作用

- 公开了一个数据集

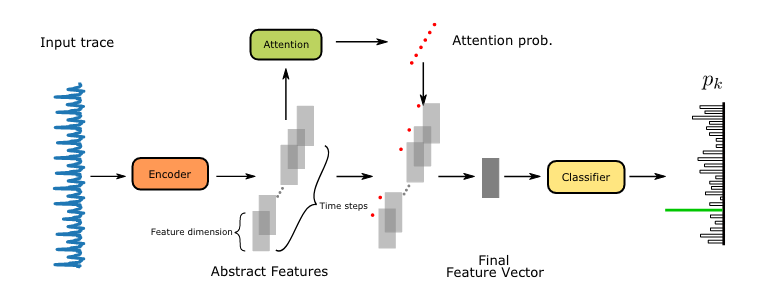

模型整体架构

在本文中作者将自编码器(Encoder层)、注意力机制、区分器(CNN、MLP)融合在一起,以此来发动对原始能量迹的攻击。

自编码器层(堆叠自编码器LC层组合)

研究思路

作者认为在worse case下,如果硬件设备上了掩码(N阶)会导致攻击者需要一段很长的时间样本序列来进行分析,目前已有许多工作利用CNN、MLP等深度学习方法来完成在指定数据集上的攻击,但是现实场景下能量迹的数量如DPAv4.2有超过1,600,000个样本点,ASCAD有250,000个样本点(原文的话),如果此时攻击者无法基于灰盒模式对能量迹进行兴趣点区间的提取,那么考虑对原始能量迹发起端到端攻击是有意义的。

此外,MLP在特征数量过高的时候会有过拟合风险,CNN在针对高维数据构建多层网络时设计较为棘手,为此作者提出四点设计原则:

- 避免在高维层之间使用全连接层

- 避免对高维数据扩大特征维度

- 前几层应做特征提取

- 分类器之前的层应能够提取出细粒度的特征

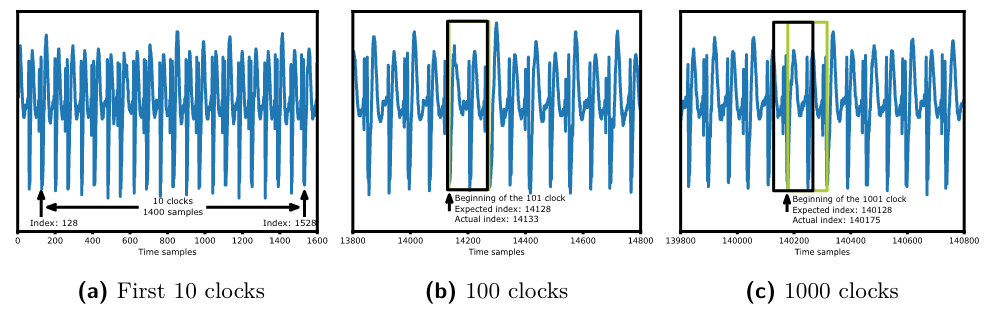

(局部连接)LC层与卷积层

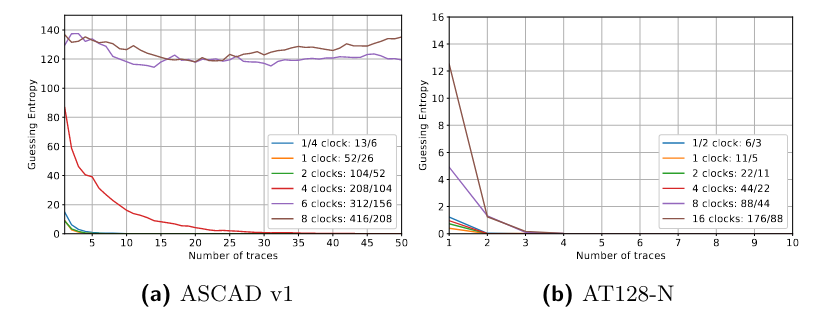

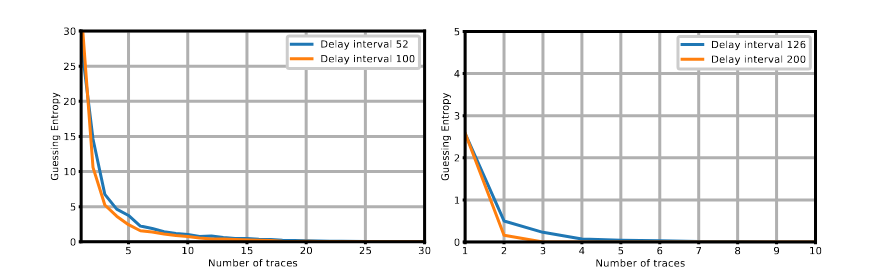

如图2所示,由于在滑动滤波器时起始位置和设备的时钟周期不一定总是对齐的,从而导致预期位置与实际位置不同,由于偏差的影响,卷积层无法共享同一个权重,但是步长为1的情况下可以提取去同步的特征。

LC层进关注独立的区域,不会受到距离较远的噪声的影响,即仅关注小范围区间。

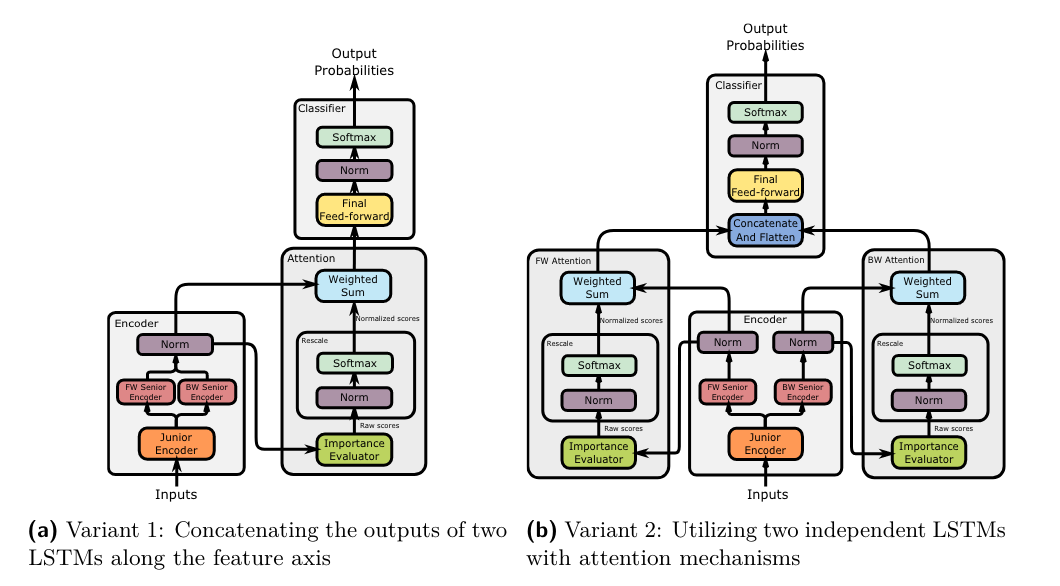

LSTM

用的seq2seq模式构建lstm的模型,没有实现过先不展开。

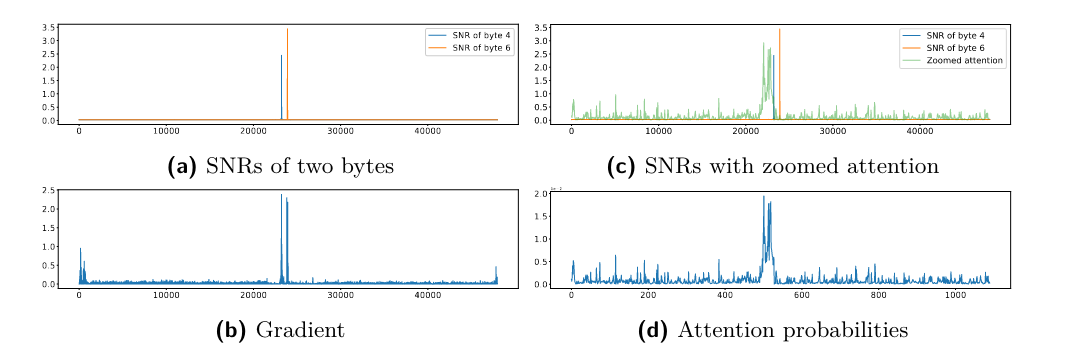

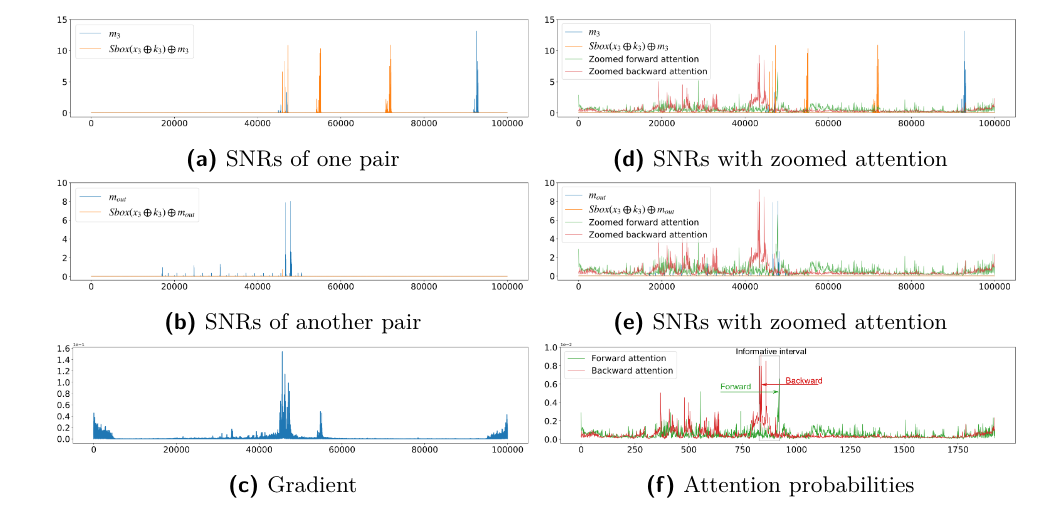

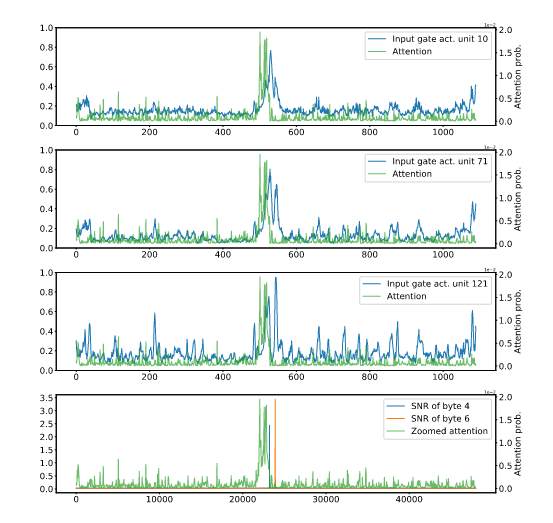

Attention

本人认为比较重要的就是注意力这块,在经过上层编码器Encode之后的"Embeddings"仍然对应有不同的权重,即存在噪声特征,在LSTM前我们必须对提取到的这些特征分配不同的权重,是模型关注重要泄漏点,本文使用了Bahdanau等人[1]提出的模型,此外,作者认为在编码器之后使用注意力机制是不合适的。

分类器架构

实验结果

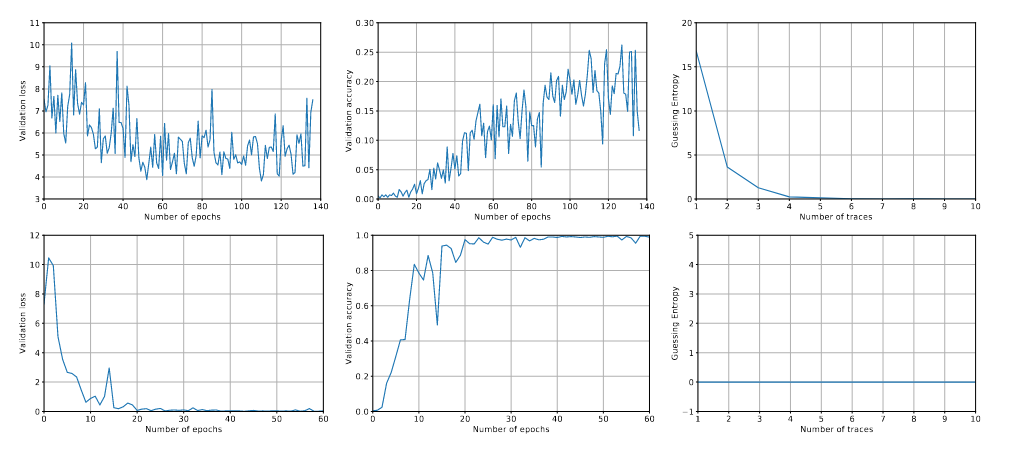

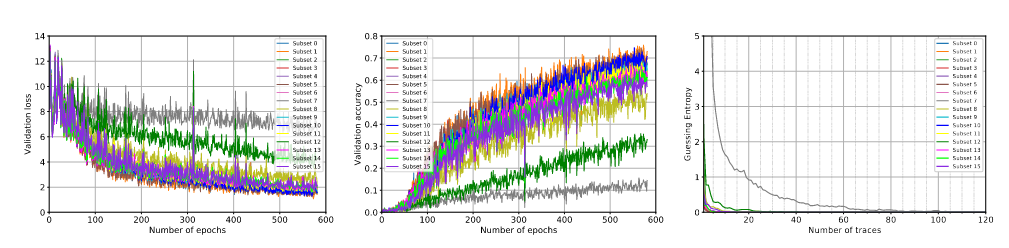

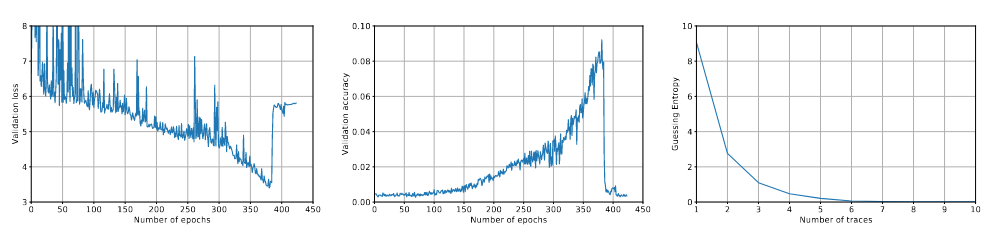

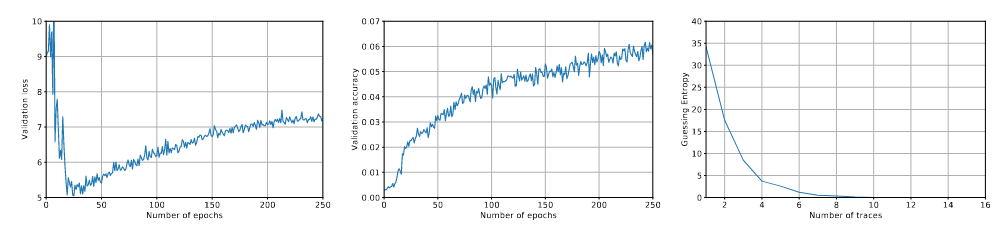

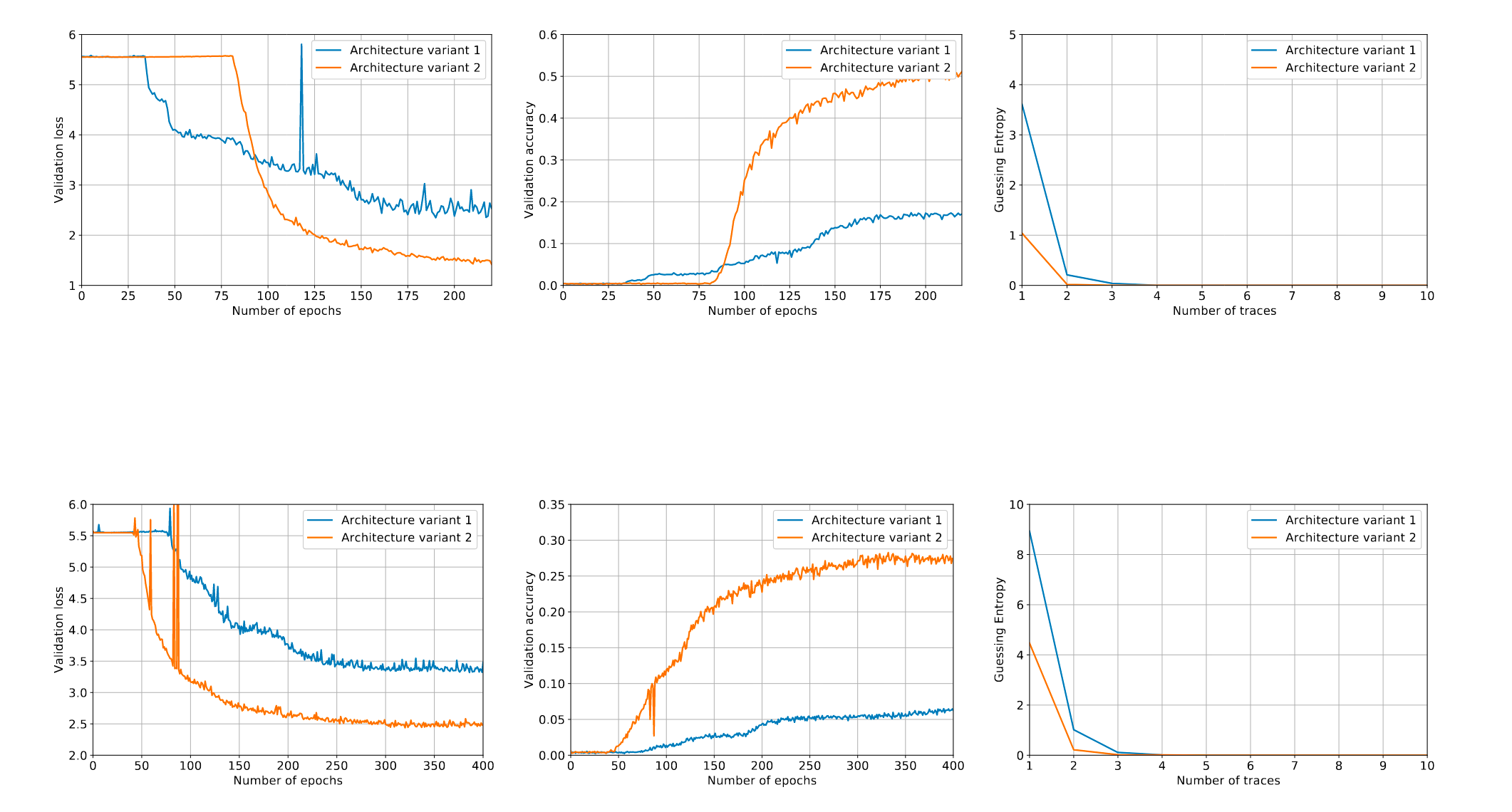

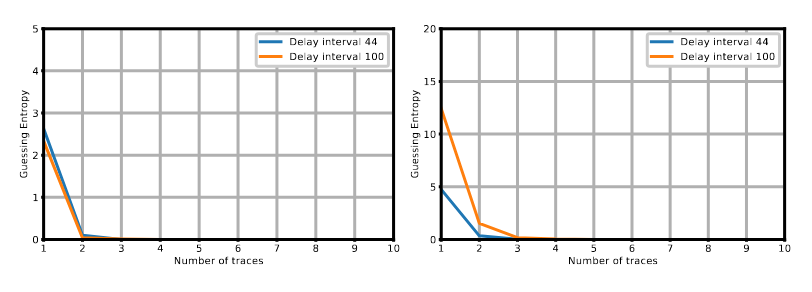

在同步数据集上结果

这里我并没有做过类似的实验,可能图标题有误,但是这个实验可以尝试集成到mlscat里,在写writing时充任务量。

总结

本文提供了一个端到端的侧信道攻击框架,攻击者仅需输入一条原始能量迹即可完成对某一字节的攻击。

Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate[J]. arXiv preprint arXiv:1409.0473

, 2014. ↩︎